Premessa: che cosa sono i sistemi di intelligenza artificiale? Il termine intelligenza artificiale (di seguito anche “IA”) indica una famiglia di tecnologie in rapida evoluzione in grado di condurre a risultati assimilabili all’intelligenza umana.

L’IA si fonda su diversi approcci da cui derivano differenti tecniche algoritmiche: nell’approccio induttivo o Machine learning (c.d. ML) la macchina sintetizza la propria conoscenza sulla base dell’osservazione empirica dei dati, imparando da questi tramite un processo di generalizzazione.

I vantaggi e i rischi dei sistemi di intelligenza artificiale sviluppati in ambito bancario e assicurativo

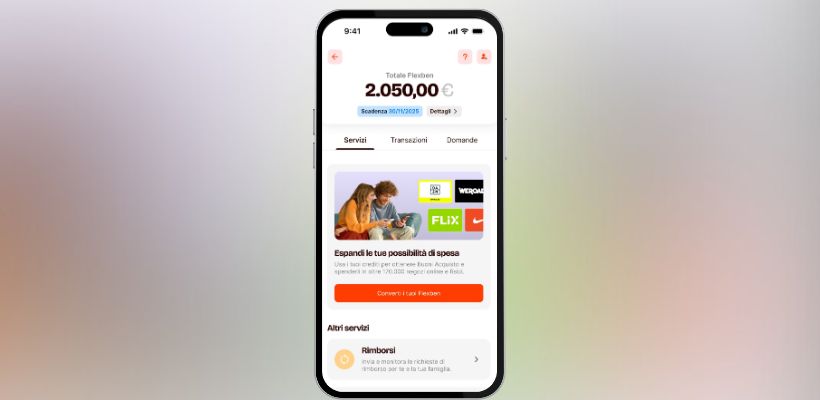

Il metodo di ML è già utilizzato dalle banche e anche dalle assicurazioni, ad esempio, nel campo del c.d. credit scoring, per valutare l’opportunità di erogare il mutuo o per determinare il premio assicurativo. È stato, da tempo, riconosciuto, difatti, che l’accesso a nuovi dati e l’utilizzo di tecnologie innovative garantiscono la fornitura di migliori servizi assicurativi e bancari, attraverso una contrattazione più precisa e adatta alle esigenze della clientela.

Tuttavia, è opportuno segnalare che lo sviluppo di sistemi di intelligenza artificiale (connessi all’utilizzo di tecnologie inappropriate), che non sia accompagnato da una attenta valutazione dei rischi, può portare a considerare, esplicitamente o implicitamente, determinate circostanze rispetto ad altre, riferibili a singoli individui o gruppi sociali, incrementando così la possibilità che la selezione dei clienti risulti distorta e andando a configurare possibili forme di discriminazione. In tale ottica, l’uso di sistemi di IA rappresenta, al contempo, un’opportunità e un rischio per le entità bancarie e assicurative, che dovranno effettuare, attraverso i sistemi di governance e controllo, adeguate valutazioni e ponderazioni sull’impatto dei sistemi di IA.

La Proposta di Regolamento: l’AI Act

In tale contesto, risulta utile segnalare che, nell’ambito del quadro normativo europeo, il 21 aprile 2021, la Commissione europea ha pubblicato la proposta di regolamento del Parlamento europeo e del Consiglio che stabilisce norme armonizzate in materia di intelligenza artificiale (legge sull’intelligenza artificiale); la proposta è stata approvata dal Parlamento Europeo, con emendamenti, lo scorso 14 giugno 2023 (c.d. AI Act).

Scopo principale dell’AI Act è di promuovere l’innovazione e lo sviluppo di un’intelligenza artificiale “Made in Europe”, secondo una visione antropocentrica, che non miri a sostituire l’autonomia umana e garantisca i diritti fondamentali della persona ed i valori dell’Unione europea.

L’AI Act segue un approccio basato sul rischio, per distinguere i diversi sistemi di intelligenza artificiale e, a seconda di tale distinzione, adottare nei confronti di fornitori ed operatori del mercato una serie di obblighi e procedure per ridurre i rischi di discriminazione dei singoli individui o di gruppi di individui.

Tra i sistemi “ad alto rischio” figurano, in particolare:

- i sistemi di profilazione della clientela destinati a essere utilizzati per valutare il merito di credito o l’affidabilità creditizia delle persone fisiche (già presenti nel testo originale proposto dalla Commissione) e, a seguito degli emendamenti del Parlamento Europeo;

- i sistemi di IA volti ad adottare o influenzare decisioni riguardo all’ammissibilità di persone fisiche all’assicurazione sanitaria e sulla vita, sempre che tali sistemi presentino un rischio significativo di danno per la salute umana, la sicurezza o i diritti fondamentali delle persone fisiche.

L’AI Act stabilisce, inoltre, (i) particolari obblighi per i fornitori dei sistemi di intelligenza artificiale ad alto rischio, legati alle procedure di gestione dei rischi di valutazione della conformità dei prodotti, e (ii) obblighi di monitoraggio dei sistemi successivi alla loro immissione sul mercato o alla messa in servizio. Infine, vale la pena ricordare che anche gli utenti dei sistemi di IA non sono esenti da obblighi, essendo tenuti a utilizzare i sistemi di intelligenza artificiale, conformemente alle istruzioni del fornitore, monitorandone l’utilizzo nel tempo.

Prime considerazioni

In attesa di poter valutare il testo finale del regolamento, si può, sin d’ora, ritenere che l’entrata in vigore del testo normativo, prevista tra il 2024 e il 2025, comporterà senz’altro l’onere, in capo alle banche e alle assicurazioni, quali soggetti fornitori e utenti dei sistemi di intelligenza artificiale, di integrare le procedure e di adottare policy che assicurino l’alfabetizzazione in materia di intelligenza artificiale dei propri dipendenti e il rispetto di obblighi di trasparenza nei confronti dei clienti, specialmente consumatori, al fine di tutelarsi da potenziali reclami sollevati dai clienti stessi e da sanzioni amministrative pecuniarie impartite dalle autorità di controllo.

Benché il legislatore europeo sembri limitare i rilievi di maggiore criticità ai sistemi di intelligenza artificiale forniti e utilizzati da banche e assicurazioni, l’AI Act pare estendere la sua applicazione anche agli “istituti finanziari”, al fine di identificare l’autorità di vigilanza di tali enti con l’autorità di controllo che sarà competente per la sua attuazione.

A tale riguardo, considerato che, nella versione attuale dell’AI Act, non viene fornita una definizione di “istituti finanziari”, è ragionevole attendersi che il perimetro di applicazione del regolamento subisca, nel corso della stesura finale del testo, ulteriori precisazioni.

Questo articolo è stato pubblicato sul numero di luglio/agosto 2023 di AziendaBanca ed è eccezionalmente disponibile gratuitamente anche sul sito web. Se vuoi ricevere AziendaBanca, puoi abbonarti nel nostro shop.